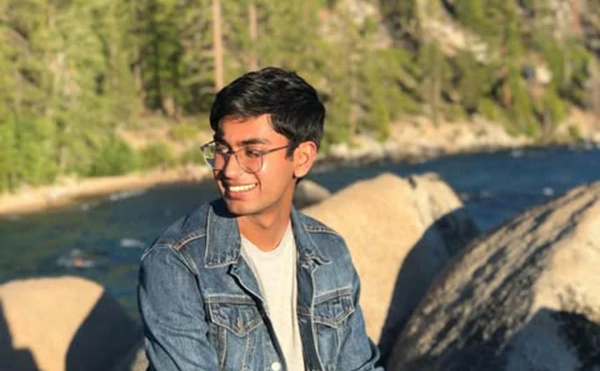

Сухира Баладжи, обнаружили мертвым в его квартире в Сан-Франциско.

Мать погибшего разработчика ChatGPT считает, что неизвестные подстроили его убийство и подкупили полицию. 26-летнего Сухира Баладжи нашли мёртвым в собственной квартире в конце осени 2024-го. Незадолго до смерти он обвинил компанию OpenAI в нарушении авторского права и уволился со скандалом.

Мать инженера, Пурнима Рамарао, дала интервью Такеру Карлсону, где заявила, что следователи намеренно проигнорировали часть вещественных доказательств на месте преступления. Так, по заявлению властей, Баладжи застрелился — но повторное вскрытие частным специалистом показало, что пуля вошла в голову под углом 30–45 градусов относительно мозга. Проще говоря, разработчик почему-то целился в район шеи со стороны лба и, как следствие, не сумел попасть в мозг.

Почти вся квартира Баладжи оказалась в пятнах крови из-за инцидента, а среди них нашлись остатки парика с волосами неизвестного — сам же разработчик никогда не носил парик. Специалисты, проводившие первое вскрытие, проигнорировали тупую травму на голове инженера. Согласно заключению врача, который проводил частное вскрытие, Баладжи мог получить эту травму во время борьбы с неизвестным нападавшим.

В интервью Такеру Карлсону Рамарао отметила и другие странности. У следователей ушло почти 15 минут, чтобы установить причину смерти разработчика. Оба входа в квартиру Сухира Баладжи оказались вне поля зрения камер наблюдения. Наконец, перед смертью он не проявлял никакого интереса к суициду и не вводил связанных с ним поисковых запросов. Наоборот, разработчик мечтал о продолжении карьеры в IT — его считали ценным и опытным специалистом даже по меркам крупнейших корпораций.

Летом 2024-го Баладжи заявил, что ChatGPT нарушает закон, поскольку нейросеть сперва обучается на интернет-материалах для ознакомления, а затем вступает в прямую конкуренцию с их создателями. В OpenAI не согласились с аргументами разработчика и сослались на «широко признанные правовые прецеденты».

По мнению Баладжи, использование OpenAI при разработке ChatGPT чужой интеллектуальной собственности, защищенной авторским правом, нарушает соответствующий закон. Мужчина настаивал, что подобные технологии принесут обществу больше вреда, чем пользы, так как они разрушают «коммерческую жизнеспособность» людей, предприятий и интернет-сервисов, когда-то создавших материалы, используемые для обучения чат-ботов.

На компании, занимающиеся развитием технологии искусственного интеллекта, в том числе на OpenAI, за последние два года было подано множество исков от программистов, художников, звукозаписывающих компаний, авторов книг и СМИ, отмечает газета. Все истцы утверждают, что эти компании незаконно используют их авторские материалы для обучения своих систем. Иск подала и сама NYT — редакция обвинила OpenAI и ее партнера, компанию Microsoft, в незаконном использовании миллионов опубликованных статей для создания чат-ботов, которые теперь конкурируют с изданием в качестве источника надежной информации. Обе компании обвинения отрицают.

OpenAI также не согласилась с утверждениями Баладжи. Компания заявила, что обучает модели искусственного интеллекта, опираясь на общедоступные данные и основываясь на принципе добросовестного использования. В этом контексте она сослалась на «широко признанные правовые прецеденты».

«Мы считаем этот принцип справедливым по отношению к создателям, необходимым для новаторов и критически важным для конкурентоспособности США», — говорилось в заявлении организации.

<iframe width="560" height="315" src="https://www.youtube.com/embed/eohVK1dOPZk?si=FqLAe0ATpl9U0mSy" title="YouTube video player" frameborder="0" allow="accelerometer; autoplay; clipboard-write; encrypted-media; gyroscope; picture-in-picture; web-share" referrerpolicy="strict-origin-when-cross-origin" allowfullscreen></iframe>